2024.08.02イベント開催報告

【レポート】第5回 AI×コンテンツ研究会「音声メディアにおけるAI活用」

CiP協議会ではAIの登場によって大きく変わりつつあるコンテンツの制作、流通、受容についての変化を共有し、日本から新たな利活用の事例を作り世界に打って出る機会を探るプロジェクト「AI×コンテンツ研究会」をスタートし、7/24に第5回 AI×コンテンツ研究会「音声メディアにおけるAI活用」を実施しました。

登壇者 *敬称略

・井島勇祐氏(NTT人間情報研究所 特別研究員)

・鬼頭武也氏(YouTube Japan / Google ディレクター / 日本音楽パートナーシップ統括責任者)

・花光宣尚氏(慶應義塾大学大学院メディアデザイン研究科 特任助教)

モデレーター:菊池尚人(デジタル政策財団 理事)

■レポート

花光氏のAIホットトピックを皮切りに井島氏よりNTT人間情報研究所の音声合成技術の取組について、鬼頭氏よりYouTubeでの生成AI関連の取組についてプレゼンテーションを行いました。

【AIホットトピック:花光氏】

ここ数週間の動きとして下記のトピックが挙げられました。

●Googleのトライアル

・Music Canvas:「絵を描くと音を生成してくれる」もの

・MusicFX;例えば「Tokyo midnight jazz」と入れるとそれに合わせた音楽を作ってくれる。

●AIデバイス「rabbit r1」

・花光氏が「rabbit r1」を入手し、実物を披露。

・セキュリティなどの点ではネガティブな反応がある一方、コアのAI部分についての批判はない。

・日本は小型デバイス(ポケベル、ガラケー、ウォークマン、たまごっちなど)の活用が上手く親和性が高いのではないかと思う。

●生成AIを活用したコンテンツの増加

・生成AIだけで長編映画を作る国内の試み「generAIdoscope」

・米国のAIフィルムコンテスト「Project Odyssey」

【井島氏】

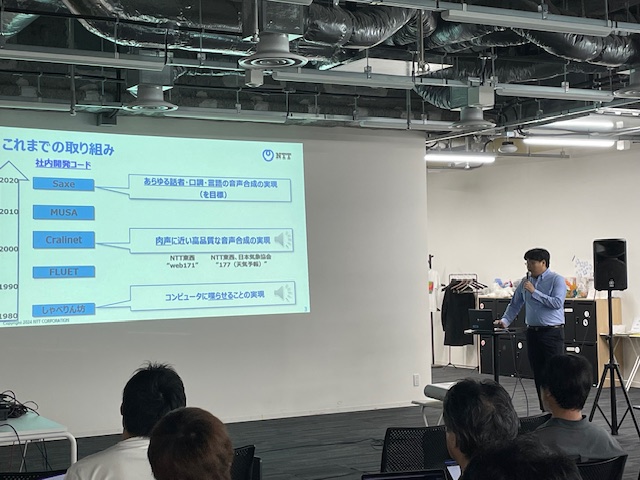

NTT人間情報研究所でのAIを活用した最新の音声合成の取り組みについて紹介されました。

●音声合成の進化

・40年前の合成音声(しゃべれればすごかった=ものすごく機会感のある音声)

・15ー20年前(誰か一人の声でいいので品質の高い声を実現していった:カーナビや電話の自動応答には問題のないレベル)

音声合成(テキストを入力して発声させる)の適用先は、基本的には「一方向」で情報を案内するケースを中心に使われている。

●一方向伝達からインタラクション利用へ

この1-2年は「単なる情報提供=一方向の情報伝達用途」から、人と機械のインタラクション向けであったり、エンタメ向けへの応用といった分野が増えつつある。

その背景としては「音声合成技術が良くなって品質が上がってきたこと」、「実際に人間がしゃべるだけではできないことが機械的にはできるようになってきたこと」がある。

また音声に限らず、生成系の技術の進化=LLMに始まり、画像など生成AI系の進化に伴い人と機械のインタラクション環境が大きく変わってきた中で、「音声をどのように人に近づけるか」が大きなトピックになってきている。

しかし商用ベースでは高いコストがまだハードルになっているのが現状。

●自分にできないことを声ができるように

目指しているのは、人手をかけることでかかっているアノテーションのコストや現在、高性能化に必要なGPUを使用せず一般的な環境で動く音声合成技術。

詳細の説明に先立ち下記デモンストレーションが行われた。

自分の声

→その声で実際には話していない文章(音声合成)

→さらに同内容を自分の声で英語で発声

中国語の子供の声

→その声で日本語と英語

韓国語の男性の声

→その声で日本語と英語

数秒のサンプルを元に別の言語を話させることができる。

●仕組みの説明

2つの技術の組み合わせ

1. ゼロショット音声合成

既にある大量の音声を学習済みの音声合成モデルに、数秒の声を入力すると「声の特徴情報」を抽出し、最終的には「話させたいテキスト」と「声の特徴データ」から、「私の声でテキストを読む」ことが実現されていく。

2. 日本語で収録した「声の特徴」を、ほかの言語にも適用できるようにする技術

アニメーションのキャラクターなど特徴的な声でも5-10分ほどのデータを入力することでかなり違和感のないものを作ることができる。

そこでアニメーションや有名タレントなどの実際の事例が紹介された。

まとめとして「状況で狙った演技をさせる」難しさと「権利者の権利をどのように担保するべきか」が課題として挙げられました。

【鬼頭氏】

YouTubeの音楽生成AIの取り組みについて、まとめて紹介がされた。

●YouTubeの生成AIに対する考え方

2023年8月21日に「AI music principle」をアナウンス。

・テックの企業が権利者や文化を無視して開発を進めないという宣言

・一次創作と二次創作(クリエイションを活性化するクリエータ)の両面を見ていく、という宣言

・AIについても大規模投資を行いインフラ整備を行う、という宣言

など。

●YouTube AI music インキュベータ

アーティストに直接Googleの開発中の音楽生成AIプロダクツを触ってもらい、フィードバックを得ながら開発を進めるプロジェクトを立ち上げた。

日本ではクリプトンフューチャーメディアを通じて、ユーザーであるボカロPの方々を含めてフィードバックをもらっている。

●YouTubeの生成AIへの取り組み

(1)プロフェッショナル音楽制作支援「musicAIサンドボックス」

元のファイルを画面にドロップし、テキストで「ハミングしたメロディラインをサックスのソロ風に仕上げてくれ」と指示をすると、今流したようにボーカルのハミングがサックスの音色でメロディになるというデモンストレーションがあった。

プロのクリエータの音楽制作支援になるような機能群のことを「YouTube musicAIサンドボックス」と呼んでおり、「YouTube AI music インキュベータ」に参加のアーティストに提供されている。

(2) ファン参加・UGCの作成支援「DreamTrack」

「text to musicのプロダクト」に「(許諾を得た)具体的なアーティストのvoice bank」とアーティストに合った「歌詞の体現機能」が連携されたもの。単に音楽を作るというよりは、そうして生成した音楽をBGMにショート動画(YouTube short)を作ってもらうことを期待したもの。つまり、YouTube shortのBGM作成機能を提供しているともいえるもの。

米国の一部のYoutuber(クリエータ)に使ってもらいながらフィードバックをもらい、開発を進めている。

(3)音楽以外の動画規格制作支援

・Dream Screen:動画の「背景動画」を「text to video」で作成するもの。

・aloud:自動翻訳吹き替え機能。アップロードした日本語で自分がしゃべった動画を、同じ声色で他言語への翻訳吹替ができるもので、英・仏・ポルトガル語で現在試験運用を行っている。

・YouTube Studio:最近の動向や視聴者の傾向をAIが分析し、サジェスト機能と動画作成のテンプレート機能が一元化した、より簡単にアイディア時点から動画を生成AIで簡単に作れる機能。

(4) 器としてのYouTube

生成AIを使って作成した動画をアップロードする際にはチェックボックスにチェックすることで開示責任を明確にすることを促す。

近い将来YouTubeにアップロードされた生成AIによってつくられたコンテンツに関しては、AIによる検知により、自動的に生成AIによる製作物として表示できるようにしていく。

#PROJECT関連プロジェクト

イベント一覧へ

イベント一覧へ